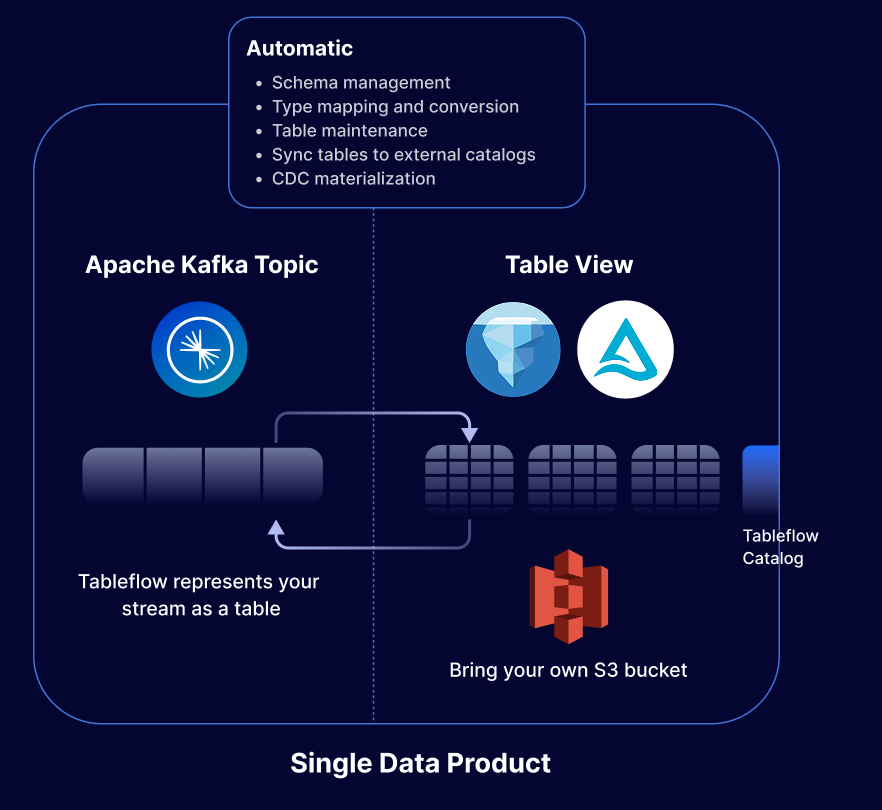

Kafka Topic を Apache Iceberg® または Delta Lake テーブルとして簡単に表現

数回のクリックで Kafka Topic と関連するスキーマを Apache Iceberg® (一般提供) や Delta Lake (オープンプレビュー) などのオープンテーブル形式で表現し、任意のデータウェアハウス、データレイク、または分析エンジンにフィードできます。

より少ない労力とコストで Topic をテーブルに移行

Kafka Topic を Iceberg テーブルまたは Delta テーブルとして表現することで、ブロンズテーブルとシルバーテーブルの形成プロセスを簡素化し、エンジニアリングの労力と計算コストを削減します。

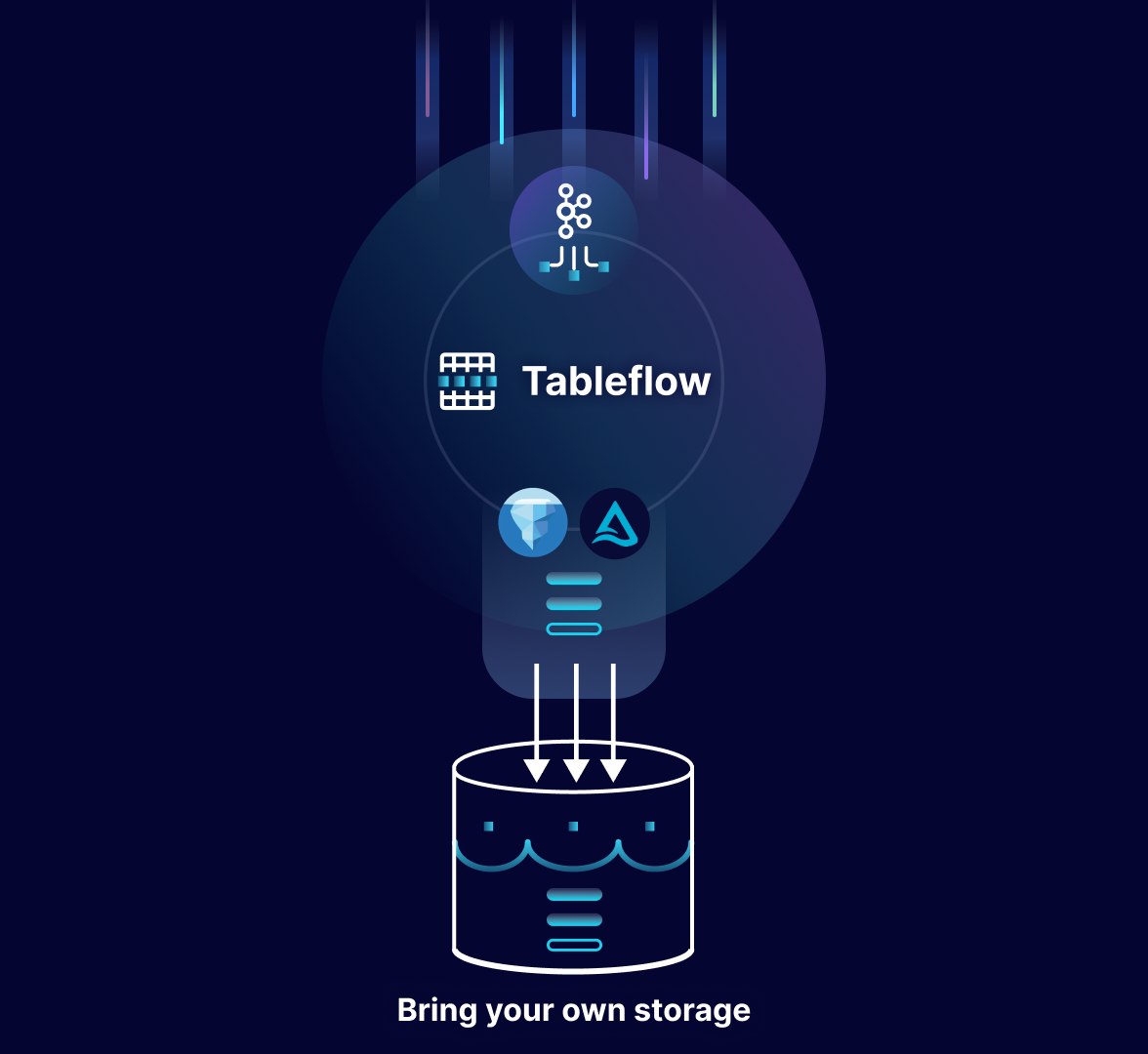

独自のストレージを持ち込むことで柔軟性が向上

最新の Iceberg または Delta テーブルを一度保存し、互換性のある独自のストレージで何度も再利用することで、柔軟性、コスト削減、セキュリティを確保します。

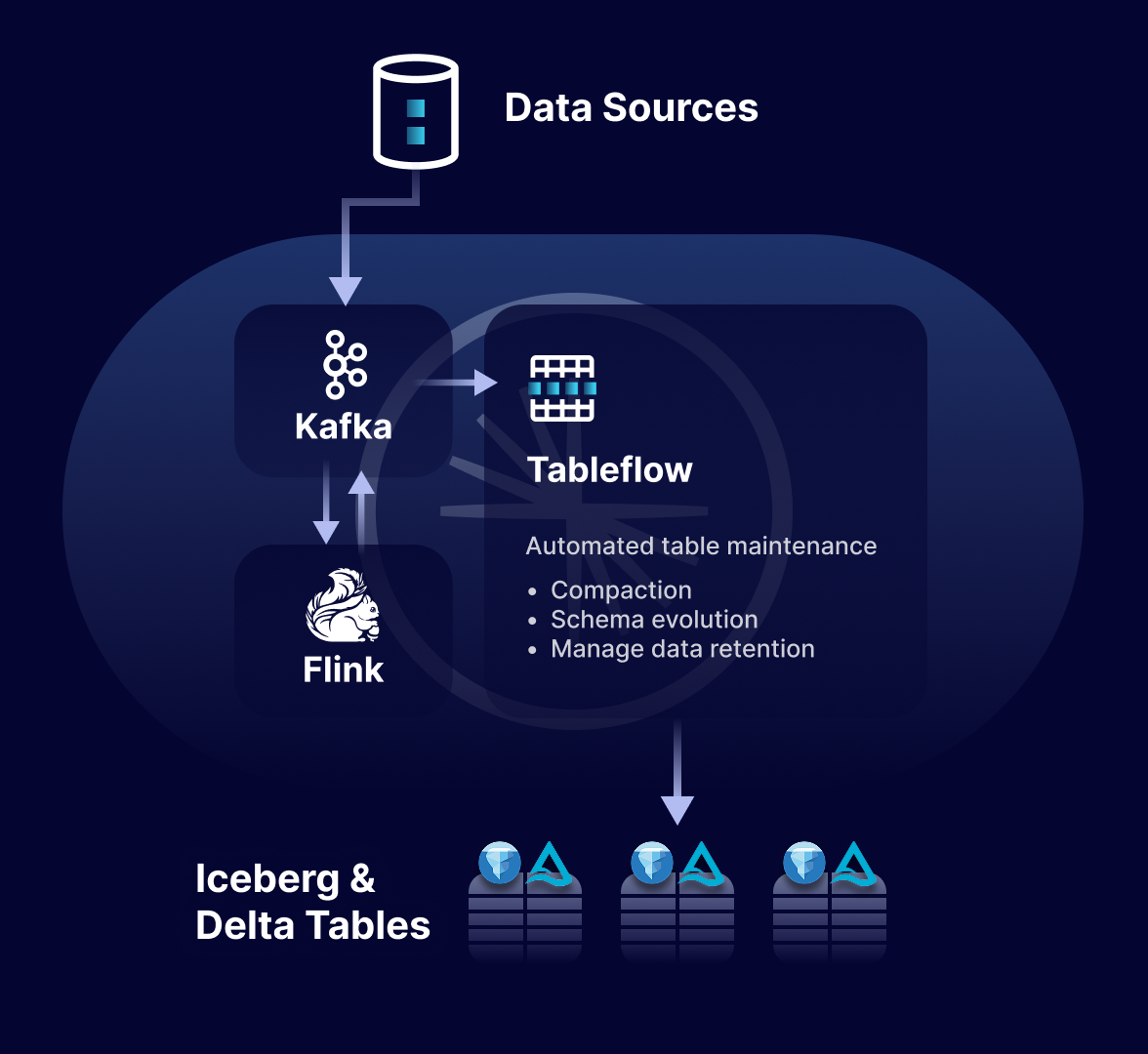

パートナーエコシステムによるゴールド標準テーブルの構築

コマーシャルパートナーとエコシステムパートナーを活用してブロンズテーブルやシルバーテーブルをゴールドスタンダードテーブルに変換し、AI と分析の幅広いユースケースに対応

強力な読み取りパフォーマンスと自動データメンテナンス

ファイルの圧縮を通じて読み取りパフォーマンスを継続的に最適化し、小さなファイルをより大きく管理しやすいファイルに統合することで、効率的なデータの保存と取得を維持します。

リソース

Confluent の活用を今すぐ開始

登録後の30日間で利用できる$400のクレジットを無償提供中